안녕하세요! 은공지능 공작소 운영자 파이찬입니다. 오늘은 TF-IDF 벡터화에 대한 내용을 다루겠습니다.Feature extraction 기법입니다.

VIDEO

1. TF-IDF의 개념

TF-IDF의 풀네임은 Term Frequency - Inverse Document Frequency 입니다.

TF-IDF 는 일종의 특징 추출(Feature extraction) 기법입니다.raw data에서 특징을 뽑아내는 것 을 의미합니다.'수치화'입니다.

여러가지 특징 추출 기법 중 가장 기본적이 count 기반 특징 추출기법입니다.CountVectorizer 가 바로 이것입니다.의미 없는 단어에 높은 수치를 부여 할 수 있다는 것입니다.

이러한 단점을 해결할 수 있는 것이 TF-IDF입니다.

이제 다시 한번 정확하게, TF, DF, IDF의 의미 를 짚고 넘어가겠습니다. 위의 그림을 통해 의미를 이해하시면 됩니다. + 유튜브 동영상에는 설명이 빠진 것이 있어 보충합니다. TF-IDF에서 한 글자의 단어(Term)는 단어 사전에서 제외 됩니다. 위의 문서들에 등장하는 단어 중 'I' 나 'a' 같은 단어에 이에 해당됩니다.

DF의 개념은 혼동될 수 있으니 조심 하셔야 합니다.'DF'는 문서의 빈도 를 나타냅니다. DF = 4로 잡으시면 안 된다 는 말씀입니다.

비록 단어의 등장 횟수는 4번이지만, 해당 단어를 가진 문서는 총 3개 이기 때문에 여기서 home의 DF는 3 으로 잡는 것이 정확합니다.

마지막으로 IDF의 개념을 잡고 넘어가겠습니다. IDF는 DF에 Inverse 를 붙여준 것입니다.큰 값이 작은 값으로 확 줄어드는 효과 를 낼 수 있습니다.

from sklearn.feature_extraction.text import TfidfVectorizer

text = ['I go to my home my home is very large', # Doc[0]

'I went out my home I go to the market', # Doc[1]

'I bought a yellow lemon I go back to home'] # Doc[2]

tfidf_vectorizer = TfidfVectorizer() # TF-IDF 객체선언이제 본격적으로 코드 실습을 시작하겠습니다.총 3개의 문서 가 담긴 데이터입니다.TfidfVectorizer라는 모듈을 사용하여 객체를 선언 해주면 됩니다.

tfidf_vectorizer.fit(text) # 단어를 학습시킴

tfidf_vectorizer.vocabulary_ # 단어사전을 출력

sorted(tfidf_vectorizer.vocabulary_.items()) # 단어사전 정렬output:

[('back', 0),

('bought', 1),

('go', 2),

('home', 3),

('is', 4),

('large', 5),

('lemon', 6),

('market', 7),

('my', 8),

('out', 9),

('the', 10),

('to', 11),

('very', 12),

('went', 13),

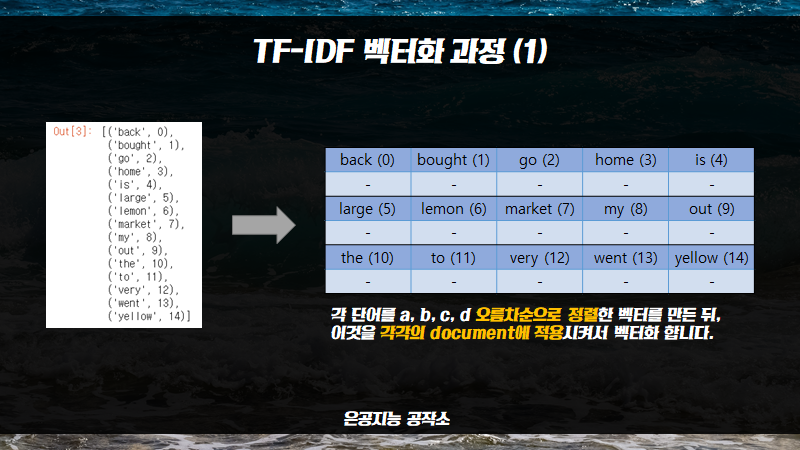

('yellow', 14)]단어 사전을 정렬해서 출력한 모습입니다.한 글자 짜리 단어들은 제외 하고 단어 사전이 만들어졌습니다.오름차순 으로 순차적으로 인덱스가 할당된 모습입니다.

2. TF, DF, IDF 벡터화 과정의 이해

tfidf_vectorizer.idf_output:

array([1.69314718, 1.69314718, 1. , 1. , 1.69314718,

1.69314718, 1.69314718, 1.69314718, 1.28768207, 1.69314718,

1.69314718, 1. , 1.69314718, 1.69314718, 1.69314718])이제 TF, DF, IDF 벡터화 과정에 대해서 설명드리겠습니다. IDF 벡터화의 결과물 입니다.

tfidf_vectorizer.idf_.shapeoutput:

(15,)코드의 뒤에 .shape를 붙여서 결과를 확인해 보십시오.(15, ) 라는 결과가 출력이 됩니다.단어 사전의 단어수와 일치 합니다.

tfidf_vectorizer.transform(text).toarray()output:

array([[0. , 0. , 0.2170186 , 0.4340372 , 0.36744443,

0.36744443, 0. , 0. , 0.55890191, 0. ,

0. , 0.2170186 , 0.36744443, 0. , 0. ],

[0. , 0. , 0.24902824, 0.24902824, 0. ,

0. , 0. , 0.42164146, 0.3206692 , 0.42164146,

0.42164146, 0.24902824, 0. , 0.42164146, 0. ],

[0.44514923, 0.44514923, 0.26291231, 0.26291231, 0. ,

0. , 0.44514923, 0. , 0. , 0. ,

0. , 0.26291231, 0. , 0. , 0.44514923]])위의 결과는 TF-IDF 벡터화의 최종 결과물입니다.3개 의 결과물이 나왔습니다. 대괄호로 묶인 덩어리를 세어보면 3개가 있는 것을 확인할 수 있습니다.과정을 해부 하는 것이지요!TF 벡터화, DF 벡터화, IDF 벡터화 에 대해 하나하나씩 자세히 파헤쳐보겠습니다.

왼쪽의 단어 사전은 fit 함수 를 통해 만들어준 것입니다. 이를 쉽게 그림으로 표현해보면 오른쪽과 같이 됩니다.

이렇게 만들어준 단어 사전을 통해, TF가 벡터화되는 것입니다.문서(Document)마다 하나씩 TF가 만들어집니다.총 3개의 TF 가 생성되는 것이죠.

이번에는 DF(Document Frequency)의 벡터화 과정에 대해 알아보겠습니다. DF의 벡터화도 TF 벡터화와 비슷합니다.'해당 단어가 포함된 문서의 수'라는 점을 기억해주시면 됩니다.

마지막으로 IDF(Inverse-Document Frequency) 벡터화 과정입니다. IDF 벡터화는 위의 그림처럼 일종의 자연로그 변환을 거칩니다.값이 높은 것들은 낮추고, 값이 낮은 것들은 높일 수 있습니다.

3. IDF 벡터화 해부

tfidf_vectorizer.idf_output:

array([1.69314718, 1.69314718, 1. , 1. , 1.69314718,

1.69314718, 1.69314718, 1.69314718, 1.28768207, 1.69314718,

1.69314718, 1. , 1.69314718, 1.69314718, 1.69314718])이제 위와 같은 수치들을 직접 구해볼 것입니다. DF부터 만들어야 합니다. 그냥 아래 코드를 복붙 해주세요~ 수고는 제가 합니다

import numpy as np

DF_vec = np.array([1, 1, 3, 3, 1,

1, 1, 1, 2, 1,

1, 3, 1, 1, 1])DF 벡터를 위와 같이 만들어 주면 됩니다.

def idf_func(n, df):

import numpy as np

rst = np.log((1+n)/(1+df)) + 1

return rst다음으로 DF를 IDF로 로그 변환해주는 함수를 만들어 줍니다.

idf_func(3, DF_vec)output:

array([1.69314718, 1.69314718, 1. , 1. , 1.69314718,

1.69314718, 1.69314718, 1.69314718, 1.28768207, 1.69314718,

1.69314718, 1. , 1.69314718, 1.69314718, 1.69314718])tfidf_vectorizer.idf_output:

array([1.69314718, 1.69314718, 1. , 1. , 1.69314718,

1.69314718, 1.69314718, 1.69314718, 1.28768207, 1.69314718,

1.69314718, 1. , 1.69314718, 1.69314718, 1.69314718])함수를 통해 구한 것과 idfVectorizer로 구한 값이 정확히 같게 나왔습니다.로그 변환 방식을 이해하는 것입니다. +

4. TF-IDF 벡터화 해부

tfidf_vectorizer.transform(text).toarray()output:

array([[0. , 0. , 0.2170186 , 0.4340372 , 0.36744443,

0.36744443, 0. , 0. , 0.55890191, 0. ,

0. , 0.2170186 , 0.36744443, 0. , 0. ],

[0. , 0. , 0.24902824, 0.24902824, 0. ,

0. , 0. , 0.42164146, 0.3206692 , 0.42164146,

0.42164146, 0.24902824, 0. , 0.42164146, 0. ],

[0.44514923, 0.44514923, 0.26291231, 0.26291231, 0. ,

0. , 0.44514923, 0. , 0. , 0. ,

0. , 0.26291231, 0. , 0. , 0.44514923]])이제 TF-IDF 벡터화를 해부해보겠습니다. 위의 벡터 수치들을 직접 만들어 보는 것 이 저희의 목표입니다.L2정규화 까지 해야

최종 TF-IDF는 위와 같이 크게 2단계 를 거쳐서 산출됩니다.원소곱 해줍니다.L2 정규화 를 해줍니다.벡터화의 결과를 좀 완만하게 만들 수 있습니다. 이렇게 2단계를 거쳐서 최종 TF-IDF 벡터가 나오게 됩니다.

tfidf_vectorizer.transform(text).toarray()[0]array([0. , 0. , 0.2170186 , 0.4340372 , 0.36744443,

0.36744443, 0. , 0. , 0.55890191, 0. ,

0. , 0.2170186 , 0.36744443, 0. , 0. ])저희의 목표는 위의 결과를 만드는 것입니다. 이는 첫 번째 Document에 해당하는 TF-IDF 벡터 입니다.

count_vec = np.array([0, 0, 1, 2, 1,

1, 0, 0, 2, 0,

0, 1, 1, 0, 0])먼저 TF 벡터부터 만들어 주겠습니다.첫 번째 문서에 나오는 단어 빈도수 를 나타내는 벡터입니다.

tfidf_vectorizer.idf_output:

array([1.69314718, 1.69314718, 1. , 1. , 1.69314718,

1.69314718, 1.69314718, 1.69314718, 1.28768207, 1.69314718,

1.69314718, 1. , 1.69314718, 1.69314718, 1.69314718])그다음으로 해야 할 것은 IDF 벡터 를 만들어주는 것입니다.TF 벡터와 여기 있는 IDF 벡터를 곱해줘야 합니다.

np.multiply(count_vec, tfidf_vectorizer.idf_)output:

array([0. , 0. , 1. , 2. , 1.69314718,

1.69314718, 0. , 0. , 2.57536414, 0. ,

0. , 1. , 1.69314718, 0. , 0. ])위와 같은 방식으로 TF벡터와 IDF벡터를 곱해줍니다.np.multiply 함수를 쓰는 것입니다.벡터 각각의 원소들의 곱셈 을 해주는 함수입니다.

from sklearn import preprocessing

tf_idf_before_l2 = np.multiply(count_vec, tfidf_vectorizer.idf_)

tf_idf_before_l2 = tf_idf_before_l2.reshape(1, -1)

tf_idf_after_l2 = preprocessing.normalize(tf_idf_before_l2, norm='l2')위와 같이 사이킷런의 preprocessing 모듈을 이용하면L2 정규화의 범위를 전체로 잡아주기 위한 것입니다.preprocessing.normalize 함수를 통해 L2 정규화를 진행 합니다.

tf_idf_after_l2output:

array([[0. , 0. , 0.2170186 , 0.4340372 , 0.36744443,

0.36744443, 0. , 0. , 0.55890191, 0. ,

0. , 0.2170186 , 0.36744443, 0. , 0. ]])tfidf_vectorizer.transform(text).toarray()[0]array([0. , 0. , 0.2170186 , 0.4340372 , 0.36744443,

0.36744443, 0. , 0. , 0.55890191, 0. ,

0. , 0.2170186 , 0.36744443, 0. , 0. ])이제 tf_idf_after_l2 의 수치가 제대로 나왔는지 비교를 해봅시다. 모든 값이 정확히 벡터라이저의 값과 일치 하는 것을 확인하실 수 있습니다.

(사진: 은공지능 공작소 작업실) 도움이 되셨다면 하단의 ♥ 버튼 클릭을 해주시길 바랍니다.감사합니다.